Function Calling vs Model Context Protocol (MCP): Những điều cần biết

Việc tích hợp Mô hình Ngôn ngữ lớn (LLM) với các hệ thống bên ngoài đã thay đổi cách doanh nghiệp tương tác với công nghệ. Những mô hình này cho phép sử dụng ngôn ngữ tự nhiên để điều khiển phần mềm, giúp tối ưu hóa quy trình làm việc và làm cho các hoạt động trở nên trực quan hơn. Tuy nhiên, để tích hợp LLM với các công cụ bên ngoài, cần thực hiện hai quy trình quan trọng:

- Dịch lời nhắc của người dùng thành các lệnh có cấu trúc (Gọi hàm – Function Calling).

- Thực thi các lệnh đó trong một hệ thống có tổ chức (Giao thức ngữ cảnh mô hình – Model Context Protocol, MCP).

Cả Gọi hàm và MCP đều đóng vai trò quan trọng trong tự động hóa dựa trên LLM. Trong khi Gọi hàm tập trung vào việc chuyển đổi ngôn ngữ tự nhiên thành các lệnh sẵn sàng thực thi, MCP đảm bảo rằng các lệnh này được thực hiện một cách hiệu quả và nhất quán. Hãy cùng tìm hiểu sự khác biệt giữa chúng và cách chúng hoạt động cùng nhau.

Cách tích hợp LLM hoạt động theo hai giai đoạn

LLM tương tác với các hệ thống bên ngoài theo quy trình hai giai đoạn: Giai đoạn 1: Gọi hàm – Chuyển đổi lời nhắc thành hành động Gọi hàm giúp LLM biến đầu vào của người dùng thành một lệnh có cấu trúc. Ví dụ, nếu ai đó hỏi, "Giá cổ phiếu của Apple tính theo USD là bao nhiêu?", LLM sẽ tạo một lệnh chứa các chi tiết cần thiết (tên công ty, đơn vị tiền tệ) để truy xuất dữ liệu chứng khoán.

Các nhà cung cấp LLM khác nhau có cách định dạng lệnh gọi khác nhau. Dưới đây là cách một số mô hình phổ biến thực hiện:

Ví dụ về Gọi hàm từ các LLM hàng đầu:

OpenAI

{

"index": 0,

"message": {

"role": "assistant",

"content": null,

"tool_calls": [

{

"name": "get_current_stock_price",

"arguments": "{\n \"company\": \"AAPL\",\n \"format\": \"USD\"\n}"

}

]

},

"finish_reason": "tool_calls"

}

Gemini

{

"functionCall": {

"name": "get_current_stock_price",

"args": {

"company": "AAPL",

"format": "USD"

}

}

}

LLaMA

{

"role": "assistant",

"content": null,

"function_call": {

"name": "get_current_stock_price",

"arguments": {

"company": "AAPL",

"format": "USD"

}

}

}

Mỗi mô hình định dạng các lệnh gọi hàm khác nhau, nghĩa là vẫn chưa có tiêu chuẩn chung. Tuy nhiên, các công cụ như LangChain giúp các lập trình viên làm việc với nhiều LLM bằng cách xử lý các biến thể này.

Giai đoạn 2: MCP – Chuẩn hóa quá trình thực thi

Sau khi LLM tạo ra lệnh gọi, yêu cầu này cần được thực thi bởi một hệ thống bên ngoài. MCP cung cấp một khung làm việc có tổ chức để xử lý các lệnh gọi, đảm bảo rằng các công cụ có thể diễn giải và phản hồi các hướng dẫn từ LLM một cách nhất quán.

MCP hoạt động như một cầu nối giữa LLM và hệ thống phần mềm bằng cách quản lý:

- Khám phá công cụ: Xác định công cụ phù hợp để thực hiện yêu cầu.

- Thực thi: Triển khai lệnh gọi hàm.

- Xử lý phản hồi: Trả về kết quả theo định dạng có cấu trúc.

Ví dụ yêu cầu MCP:

{

"jsonrpc": "2.0",

"id": 129,

"method": "tools/call",

"params": {

"name": "get_current_stock_price",

"arguments": {

"company": "AAPL",

"format": "USD"

}

}

}

Trong mô hình này, ứng dụng đóng vai trò là bộ trung gian, dịch đầu ra của LLM thành một yêu cầu tương thích với MCP. MCP sau đó đảm bảo rằng lệnh gọi hàm được thực thi đúng cách và gửi kết quả có cấu trúc trở lại LLM.

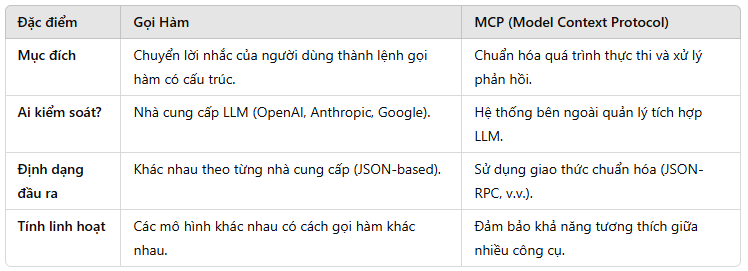

So sánh Gọi Hàm và MCP

Mặc dù cả hai đều giúp LLM tương tác với hệ thống bên ngoài, nhưng chúng có vai trò khác nhau:

Về cơ bản, Gọi Hàm là quá trình "đặt hàng nhiệm vụ," còn MCP đảm nhận việc "thực thi nhiệm vụ." Kết hợp cả hai giúp quá trình tự động hóa phần mềm bằng AI vận hành trơn tru.

Tại sao điều này lại quan trọng đối với doanh nghiệp ứng dụng AI?

Việc hiểu rõ sự khác biệt giữa Gọi Hàm và MCP là rất quan trọng đối với các doanh nghiệp tích hợp LLM vào quy trình làm việc. Dưới đây là những lợi ích chính:

- Khả năng mở rộng: MCP giúp doanh nghiệp tích hợp LLM vào nhiều ứng dụng khác nhau mà không gặp trở ngại về thực thi.

- Chuẩn hóa: MCP loại bỏ sự phụ thuộc vào định dạng lệnh gọi khác nhau của các nhà cung cấp LLM.

- Tính linh hoạt: MCP đảm bảo khả năng tương thích ngay cả khi các nhà cung cấp LLM thay đổi cách thức hoạt động của họ.

Khi việc ứng dụng AI ngày càng phát triển, doanh nghiệp tận dụng cả Gọi Hàm và MCP sẽ có một hạ tầng AI hiệu quả và có thể mở rộng dễ dàng hơn.

Kết luận

Tóm lại, cả Gọi Hàm và MCP đều đóng vai trò thiết yếu trong việc xây dựng các ứng dụng phần mềm tự động hóa dựa trên AI. Trong khi Gọi Hàm giúp chuyển đổi lời nhắc ngôn ngữ tự nhiên thành các hướng dẫn có cấu trúc, MCP đảm bảo các hướng dẫn này được thực thi một cách nhất quán và đáng tin cậy.

Đối với doanh nghiệp muốn tích hợp AI vào quy trình làm việc, việc hiểu mô hình hai giai đoạn này là chìa khóa để tối ưu hóa hiệu suất và khả năng mở rộng dài hạn. Khi các LLM tiếp tục phát triển, việc có một hệ thống tích hợp Gọi Hàm + MCP mạnh mẽ sẽ là yếu tố thay đổi cuộc chơi trong quá trình ứng dụng AI vào doanh nghiệp.

Cảm ơn các bạn đã theo dõi!

All rights reserved