[Papers Notes] Chain of Agents: Hướng đi sử dụng Multi-agents LLMs trong bài toán long contexts

Một trong những thách thức lớn nhất của LLMs là việc xử lý long context. Hiện nay chúng ta có biết được hai hướng chính để xử lý vấn đề này:

- Input Reduction: Rút gọn lại độ dài đầu vào, tiêu biểu trong phương án này là RAG, với việc chia văn bản lớn thành các đoạn nhỏ, chỉ lấy những đoạn có nội dung gần nhất với câu hỏi đầu vào.

- Context Window Expanding: Hiểu đơn giản là việc chúng ta mở rộng đồ dài tối đa mà LLMs có thể xử lý.

Nhưng ở cả hai phương án này đều gặp bất lợi và có những hạn chế riêng trong quá trình thực thi và triển khai, với phương án đầu thì sẽ dễ dàng làm mất ngữ cảnh, còn phương án thứ hai thì gặp vấn đề Lost-in-middle.

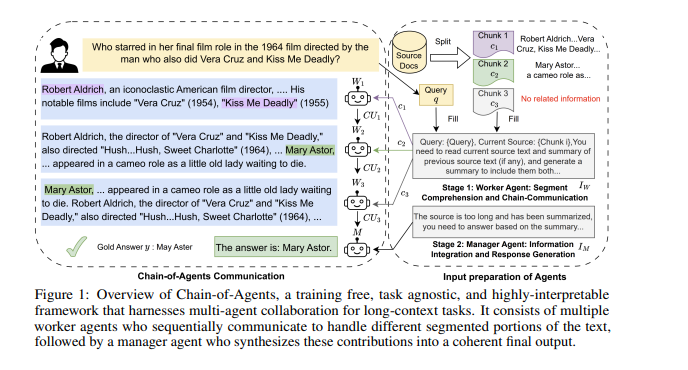

Từ đó chúng ta được giới thiệu với phương pháp Chain of Agents, ý tưởng chính của phương pháp này là việc chúng ta chia nhỏ văn bản thành các phần nhỏ rồi nhờ các Agent đọc, tổng hợp và sau đó trả lời câu hỏi từ đó.

Method

Chain-of-Agents gồm hai bước:

- Ở bước một, văn bản sẽ được chia thành các đoạn văn nhỏ, đây chính là nguyên liệu đầu vào cho các Agent Worker, các Agent này có công việc là đọc và chọn lọc các ý chính từ trong đoạn văn mà chúng được giao cho. Sau đó phần nội dung được tổng hợp đó sẽ được truyền qua cho các Agents đến hết.

- Ở bước hai, sau khi các đoạn chunk đều được xử lý thì chúng ta sẽ có một Agent Manager, chỉ tập trung vào việc trả lời câu hỏi sau khi có những tài liệu tóm tắt ở phía trước.

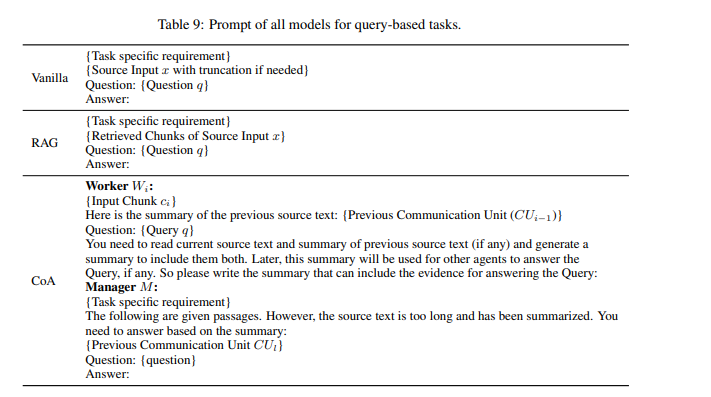

(Chúng ta có thể tham khảo phần prompt ở phía dưới.)

Time Complexity Analysis

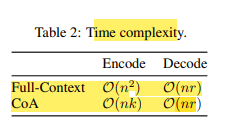

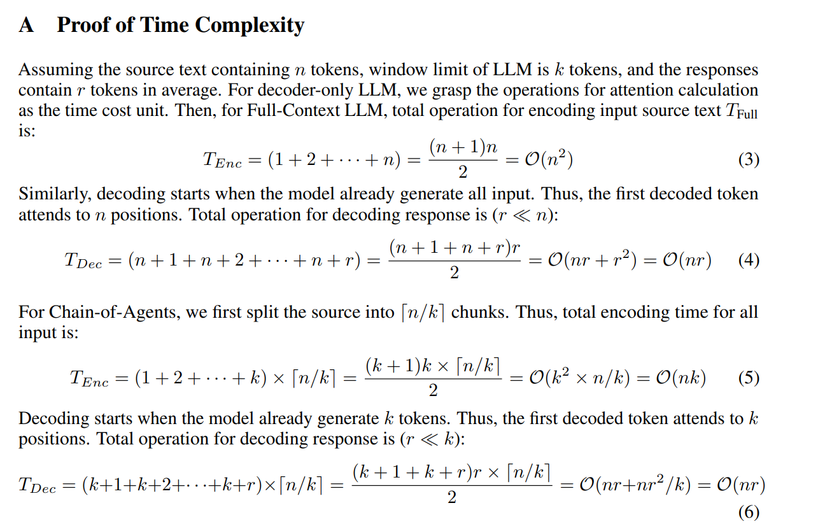

Về mặt ý tưởng thì cũng khá rõ ràng, nhưng phần mà chúng ta nên đi sâu hơn là việc liệu thời gian chạy của nó có lâu không, cx khá là dễ hiểu cho câu hỏi này vì chúng t phải chạy khá nhiều lần LLMs.

Về mặt này thì có vẻ nó vẫn làm khá tốt. Về chứng minh chi tiết thì ta có thể xem rõ hơn ở phía dưới.

Analyses

Và chúng ta sẽ có một số phân tích ở phương pháp này:

-

CoA cải thiện hiệu suất khi RAG thất bại trong việc truy xuất câu trả lời chính xác

- Phân loại các mẫu trong NarrativeQA theo vị trí của câu trả lời chính xác trong đầu ra của RAG.

- CoA vượt trội hơn RAG đáng kể khi RAG không truy xuất được câu trả lời chính xác.

- RAG hoạt động tốt hơn khi câu trả lời chính xác nằm ở đầu (gần với câu truy vấn).

-

CoA cải thiện hiệu suất trên các ngữ cảnh dài hơn

- Thử nghiệm trên BookSum, CoA cho thấy hiệu suất vượt trội so với mô hình cơ bản (Vanilla), đặc biệt khi độ dài đầu vào tăng.

- Khi độ dài mẫu vượt 400k từ, hiệu suất cải thiện của CoA đạt khoảng 100%, chứng minh khả năng xử lý tốt ngay cả khi ngữ cảnh rất dài.

-

CoA giảm hiện tượng "mất thông tin giữa chừng"

- So sánh hiệu suất của CoA và Vanilla trên vấn đề này:

- Vanilla có mức chênh lệch lớn (6.13 ± 2.17).

- CoA giảm thiểu đáng kể hiện tượng này với khoảng chênh lệch nhỏ hơn (4.89 ± 1.91).

- CoA đạt được điều này nhờ phân chia ngữ cảnh dài thành các phần nhỏ hơn cho từng agent.

- So sánh hiệu suất của CoA và Vanilla trên vấn đề này:

-

CoA hỗ trợ suy luận phức tạp qua ngữ cảnh dài

- Trong bài toán HotpotQA:

- RAG thất bại khi cần suy luận nhiều bước do thiếu liên quan ngữ nghĩa ở các bước ban đầu.

- CoA sử dụng cách tiếp cận cộng tác, với các agent làm việc tuần tự:

- Agent đầu tiên khám phá thông tin ban đầu.

- Agent sau mở rộng phạm vi thông tin.

- Agent cuối tổng hợp và hoàn thiện suy luận.

- Trong bài toán HotpotQA:

-

Nghiên cứu vai trò của Manager và thứ tự đọc

- Vai trò của Manager:

- Loại bỏ manager khiến hiệu suất giảm hơn 10% trên MuSiQue, chứng minh manager rất quan trọng.

- Thứ tự đọc:

- "Left-to-Right" (trái sang phải) có hiệu suất tốt nhất trên hầu hết các tập dữ liệu.

- Vai trò của Manager:

-

Multi-path CoA cải thiện hiệu suất hơn nữa

- Các phương pháp Multi-path (Bi-direction, Self-consistency, Permutation) cải thiện hiệu suất CoA.

- Bi-direction: Cả hai hướng đọc, "left-to-right" và "right-to-left."

- Self-consistency: Đọc từ nhiều con đường "left-to-right."

- Permutation: Đọc theo các thứ tự ngẫu nhiên.

- Các phương pháp Multi-path (Bi-direction, Self-consistency, Permutation) cải thiện hiệu suất CoA.

Conclusion

Phương án khá là thú vị và có những cải thiện nhất định. Tuy nhiên cũng có những hạn chế về việc cơ chế còn khá đơn giản cũng như chưa tận dụng hết khả năng của multi-agents hay vấn đề chi phí. Khá là có tiềm năng phát triển.

References

All rights reserved